NAŽIVO

Nórska polícia oznámila zadržanie troch bratov. Tí sú podozriví z teroristického bombového útoku na americkú ambasádu v Osle.

Ako uviedol policajný prokurátor Christian Hatlo podozriví bratia sú nórskymi občanmi irackého pôvodu a zadržali ich v Osle.

Josého Antonia Kasta slávnostne uviedli do úradu prezidenta Čile.

Francúzsky prezident Emmanuel Macron v stredu uviedol, že nemá potvrdené správy o tom, že Irán kladie námorné míny v strategickom Hormuzskom prielive, ktorý je v dôsledku vojny na Blízkom východe prakticky uzavretý.

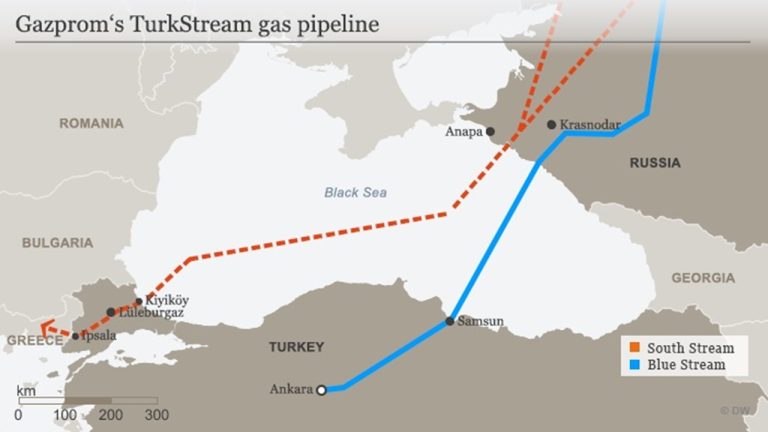

Čítať viac | 19:15Spoločnosť Slovnaft reagovala na výpadok dodávok ropy cez ropovod Družba objednaním 11 tankerov. Generálny riaditeľ spoločnosti Gabriel Szabó po rokovaní vlády uviedol, že pri súčasnom režime vie podnik zabezpečiť zásobovanie alternatívnou ropou približne do 30 dní.

Čítať viac | 18:46Poslanci Európskeho parlamentu sa na dnešnom plenárnom zasadnutí budú venovať aj návrhu správy o stratégii rozširovania Európskej únie, ktorá hodnotí súčasnú politiku rozširovania a navrhuje ako by mal proces prijímania nových štátov fungovať v nasledujúcom období.

Čítať viac | 18:33Ukrajinskí experti na boj proti dronom začali pracovať v troch štátoch Perzského zálivu, ktoré čelia útokom Iránu, uviedol v stredu ukrajinský prezident Volodymyr Zelenskyj.

Čítať viac | 18:25Rokovanie vlády za účasti prezidenta neprinieslo podľa opozičného Progresívneho Slovenska (PS) žiadne konkrétne opatrenia, ktoré by pomohli ľuďom v čase ekonomickej neistoty. Premiér Robert Fico podľa hnutia namiesto riešení opäť útočil na opozíciu a opakoval svoje výhovorky. Uviedol to predseda PS Michal Šimečka.

Čítať viac | 18:19Ústavný súd (ÚS) SR posúdi ústavnosť zmien týkajúcich sa disciplinárnych senátov, ktoré zaviedla vládna novela zákonov o sudcoch a prísediacich a o disciplinárnom poriadku Najvyššieho správneho súdu (NSS). Ustanovenia napadla skupina opozičných poslancov. ÚS v stredu prijal ich návrh na ďalšie konanie, návrhu na pozastavenie účinnosti nevyhovel.

Čítať viac | 18:04Poverený podpredseda vlády pre plán obnovy a znalostnú ekonomiku Tomáš Drucker (Hlas-SD) diskutuje s Európskou komisiou (EK) o zonáciách štyroch národných parkov, ktoré sú zahrnuté v pláne obnovy. Diskusia sa týkala aj definície starých lesov, ktorú vyžadovala Komisia a slovenská legislatíva ju nepoznala. Uviedol to po rokovaní vlády s tým, že na tom sa dohodli.

Čítať viac | 17:37Izraelský minister zahraničných vecí Gideon Saar v stredu vyzval Bezpečnostnú radu OSN, aby označila iránske Revolučné gardy za „teroristickú organizáciu“, zatiaľ čo vojna medzi Spojenými štátmi a Izraelom na jednej strane a Iránom na druhej pokračuje už dvanásty deň.

Čítať viac | 17:27V tejto chvíli robí vláda všetky kroky, nielen na domácej, ale aj zahraničnej scéne, aby čo najviac zbrzdila potenciálny rast cien pohonných látok, alebo aby ich rast na Slovensku bol menej výrazný ako v okolitých krajinách. Situáciu má kabinet na najbližšie dni plne pod kontrolou. Po absolvovaní stredajšieho rokovania vlády to vyhlásil prezident SR Peter Pellegrini s tým, že v prípade potreby je pripravený pomôcť. Zároveň kritizoval opozíciu, od ktorej očakáva konštruktívny prístup, nie zneužívanie situácie.

Opozičné Hnutie Slovensko kritizuje vládu za prelety amerických vojenských lietadiel ponad územie SR. Hnutie za 12 dní vojenského konfliktu na Blízkom východe napočítalo 594 preletov amerických vojenských lietadiel cez vzdušný priestor SR. Informovali o tom predstavitelia Hnutia Slovensko na stredajšej tlačovej konferencii v Bratislave.

Čítať viac | 16:49O pripravovanej reforme územnej samosprávy, financovaní obcí a možnostiach zapojenia malých samospráv do budúceho programového obdobia Európskej únie rokovali v stredu v Prešove starostovia malých obcí z Prešovského kraja s ministrom investícií, regionálneho rozvoja a informatizácie SR Samuelom Migaľom (nezávislý). Diskusia sa zamerala najmä na posilnenie fungovania malých samospráv, ich spoluprácu a prístup k investíciám.

Čítať viac | 16:12Prepúšťanie upratovacieho personálu na ministerstve vnútra (MV) ušetrí rezortu počas konsolidácie finančné prostriedky. Zámer nahradiť interných zamestnancov zmluvami s externými spoločnosťami na východnom Slovensku po čase ministerstvo vyhodnotí. Na základe ekonomických výsledkov sa následne rozhodne, či bude takto pokračovať aj na zvyšnom území krajiny. V reakcii na kritiku opozičného PS a policajných odborárov to pre TASR uviedol hovorca rezortu vnútra Matej Neumann.

Čítať viac | 16:04Vláda súhlasí s odmietnutím revízie medzinárodných zdravotných predpisov (IHR) Svetovej zdravotníckej organizácie (WHO) z roku 2024. Uznesenie o odmietnutí predpisov predložil rezort zdravotníctva, ktorý argumentuje možnými pochybnosťami z ľudskoprávneho a ústavnoprávneho hľadiska, opiera sa pritom o stanoviská viacerých právnických fakúlt slovenských univerzít. Vláda o tom rozhodla v stredu.

Čítať viac | 15:55Minister životného prostredia Tomáš Taraba (nominant SNS) má zabezpečiť mechanizmus vyplácania náhrad za obmedzenie bežného obhospodarovania na pozemkoch, ktoré sú zaradené do najprísnejšej zóny v národných parkoch (NP). Urobiť tak má do 31. októbra 2026. Rozhodla o tom vláda na svojom stredajšom zasadnutí.

Čítať viac | 15:49Izrael a Spojené štáty budú pokračovať v bombardovaní Iránu, kým to bude potrebné na dosiahnutie ich cieľov, vyhlásil v stredu izraelský minister obrany Jisrael Katz.

Čítať viac | 15:45Rýchlostná cesta R4, ktorá je súčasťou európskeho dopravného koridoru Via Carpatia, je podľa opozičnej strany Sloboda a Solidarita (SaS) príkladom dlhodobého zlyhávania štátu pri budovaní dopravnej infraštruktúry na východnom Slovensku. Strana tvrdí, že pomalá príprava a výstavba tejto komunikácie brzdí rozvoj regiónu, odrádza investorov a prispieva k odchodu mladých ľudí z Prešovského kraja.

Čítať viac | 15:40Na medzinárodnej spolupráci pri medicínskych krízach sa odmietnutím revízie medzinárodných zdravotných predpisov (IHR) nič nezmení. Vyplýva to z vyjadrenia ministra spravodlivosti Borisa Suska (Smer-SD), ktorý pripomenul, že SR je aj v súčasnosti viazané predpismi IHR z roku 2005. Rovnako minister zdravotníctva Kamil Šaško (Hlas-SD) deklaroval, že medzinárodná spolupráca v tejto oblasti funguje a Slovensko je rešpektovaným partnerom. Ministri to uviedli pred stredajším rokovaním vlády.

Čítať viac | 15:27Iránska armáda v stredu vyhlásila, že všetky lode patriace Spojeným štátom, Izraelu alebo ich spojencom, ktoré budú prechádzať strategickým Hormuzským prielivom, budú považované za legitímne vojenské ciele.

Čítať viac | 15:13Washingtonská polícia uzavrela okolie Bieleho domu po tom, ako v stredu nadránom prerazilo dodávkové vozidlo bezpečnostnú zábranu v blízkosti sídla amerického prezidenta. Pri incidente nebol podľa prvotných informácií nikto zranený a vodiča dodávky zadržali, informovala polícia.

Polícia vykonáva v stredu úkony v súvislosti s nálezom tela muža bez známok života v lesoparku v bratislavských Rusovciach. Jeho totožnosť doposiaľ nie je známa.

Čítať viac | 15:06Slovensko dôrazne a konzistentne odsudzuje všetky formy terorizmu, a to bez ohľadu na to, odkiaľ tieto aktivity pochádzajú alebo aké majú politické, ideologické, náboženské či etnické pozadie. V súčasnosti je potrebné o to viac apelovať na principiálny prístup a odsúdiť teroristické útoky nielen v Európe, ale rovnako na celom svete. Uviedol to minister zahraničných vecí a európskych záležitostí Juraj Blanár (Smer-SD) pri príležitosti stredajšieho Európskeho dňa pamiatky obetí terorizmu.

Čítať viac | 15:03Ústavný súd (ÚS) SR rozhodne vo veci výkladu ústavného zákona o rozpočtovej zodpovednosti. Ide o otázku, kedy má vláda SR požiadať parlament o vyslovenie dôvery po tom, ako dlh verejnej správy presiahol určenú hranicu podielu na hrubom domácom produkte (HDP). Návrh skupiny opozičných poslancov ÚS v stredu prijal na ďalšie konanie.

Čítať viac | 15:00Plány niektorých krajín uvoľniť časť svojich strategických ropných rezerv s cieľom zmierniť vplyv vojny na Blízkom východe na bezpečnosť dodávok a globálnych cien ropy sú „nepochybne súčasťou vysoko koordinovanej stratégie“, uviedol v stredu francúzsky minister financií Roland Lescure.

Čítať viac | 14:37

.jpg)